2019-10-11 , 216 , 0 , 241

4 卷积神经网络

1980年,一位法国的大学生Yann LeCun通过《Perceptron》接触到了神经元模型,这种看起来具有智慧的机器让他十分着迷,可是他发现关于神经网络的资料简直少的可怜,实际上,就像我们前面所提到的那样,在60年代已经出现的一个关于多层神经网络如何训练这个重要问题,几乎没多少人研究,更别说解决问题了。

那个时候,大多数关于神经网络的研究成果都是日本人做出来的,因为西方人已经几乎抛弃了这个领域了。在法国,由于Hopfield的振奋人心的作用,依然有一些人坚守这神经网路的研究阵地,Yann LeCun通过这些人的推荐,看到了Geoffrey Hinton 和 Terrence Sejnowski关于玻尔兹曼机的研究论文,这让他们的相遇几乎成为必然。

在一次学术会议上,Yann LeCun结识了Terrence, Terrence立即告诉Hinton,一个法国的小孩也在做与他们几乎相同的研究。

他们都意识到了求导(梯度)中链式规则的重要性,着手研究反向传播。

也可以说,这几组人几乎同时各自独立地发现了反向传播算法。

没过多久,Yann LeCun见到了Hinton,之后来到多伦多大学跟随Hinton做博士后研究工作,从那时起,他就已经开始着手现在称之为卷积神经网络的研究。

1988年,同样是在那次会议上结识的在ATT工作的研究人员将Yann LeCun招入ATT的贝尔实验室。

3年后,支持向量机和统计学习理论的大牛Vapnic也来到AT&T。

那时贝尔实验室财大气粗,专门给Yann LeCun购买了高性能的电脑Sun 4。

三个月后,在这崭新的电脑上,诞生了第一代LeNet开始字母识别的工作。

尽管LeNet非常成功,并在ATM取款机上部署了支票识别。但贝尔实验室研究的基因太过深厚,并没有将这个应用推广到更多的领域。

1994年,在Yann LeCun与另一位深度学习元老级人物Yoshua Bengio 在《Gradient-based learning applied to document recognition》中,提出了用反向传播算法训练的多层网络LeNet5,它应该是最著名的卷积神经网络了。

可没过多久,AT&T 被拆分成了三个公司,AT&T、朗讯和 NCR,贝尔实验室隶属朗讯,握有LeNet专利的却是ATM取款机制造商NCR。

作为新的实验室主管,Yann LeCun并没有坚持在利用神经网络网络继续在字符识别方面进行研究,而是主导开发了一个DjVu项目,相信很多的读者都在百度搜索过“DjVu用什么软件打开”,DjVu是一项将纸质文档扫描成数字格式的技术,这项技术是将扫描的页面的文字和背景图像分开处理,用高分辨率来还原文字,用较低的分辨率来压缩背景图片。

300dpi分辨率扫描的彩色页面可以从25MB缩小到30KB至80KB,而且图像质量十分优秀。

尽管从技术上讲DJVU几乎是完美的阅读文件格式,但是在推广能力方面,朗讯与设计了PDF的Adobe公司的面前几乎不值得一提。

LeNet5作为最早的卷积神经网络之一, 推动了深度学习领域的发展。

在那时候,没有GPU帮助训练模型,甚至CPU的速度也很慢,因此,LeNet5通过巧妙的设计,利用卷积、参数共享、池化等操作提取特征,避免了大量的计算成本,最后再使用全连接神经网络进行分类识别,这个网络也是最近大量神经网络架构的起点,给这个领域带来了许多灵感。

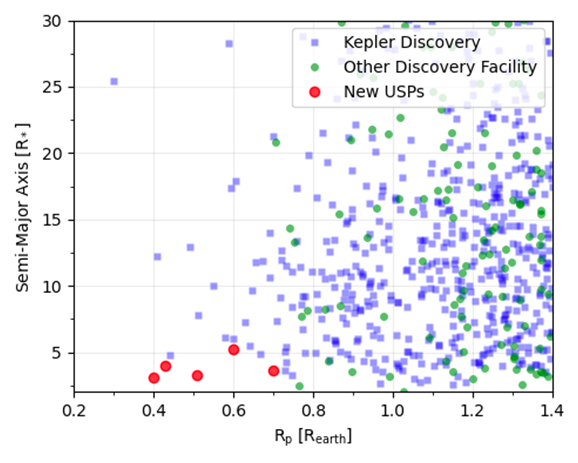

局部感知(卷积) 人类对外界的认知一般是从局部到全局、从片面到全面,类似的,在机器识别图像时也没有必要把整张图像按像素全部都连接到神经网络中,在图像中也是局部周边的像素联系比较紧密,而距离较远的像素则相关性较弱,因此可以采用局部连接的模式:局部感受野(将图像分块连接,这样能大大减少模型的参数),如下图所示:

图8 局部感受野

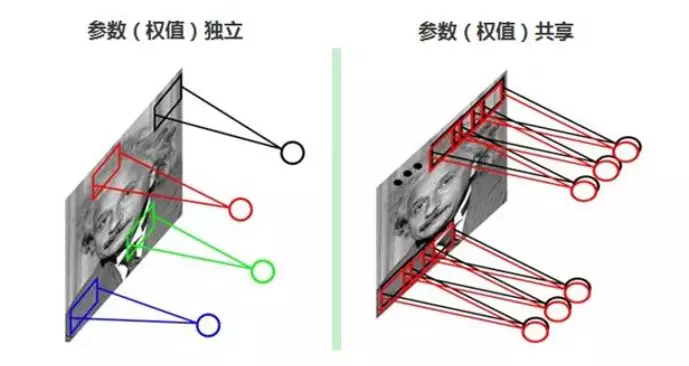

权值共享 每张自然图像(人物、山水、建筑等)都有其固有特性,也就是说,图像其中一部分的统计特性与其它部分是接近的。这也意味着这一部分学习的特征也能用在另一部分上,能使用同样的学习特征。

UfqiLong

因此,在局部连接中隐藏层的每一个神经元连接的局部图像的权值参数(例如3×3),将这些权值参数共享给其它剩下的神经元使用,那么此时不管隐藏层有多少个神经元,需要训练的参数就是这个局部图像的权限参数(例如3×3),也就是卷积核的大小,这样大大减少了训练参数。如下图所示:

图9 权值共享

池化随着模型网络不断加深,卷积核越来越多,要训练的参数还是很多,而且直接拿卷积核提取的特征直接训练也容易出现过拟合的现象。为了有效地减少计算量,CNN使用的另一个有效的工具被称为“池化(Pooling)”。

池化是一种简单粗暴的翻译,实际上就是将输入图像进行缩小(下采样subsampling),减少像素信息,只保留重要信息。通常情况下,池化区域是2*2大小,然后按一定规则转换成相应的值,例如取这个池化区域内的最大值(max-pooling)如下图所示。平均值(mean-pooling)等,以这个值作为结果的像素值。

LeNet5由7层CNN(不包含输入层)组成,上图中输入的原始图像大小是32×32像素,卷积层用Ci表示,子采样层(pooling,池化)用Si表示,全连接层用Fi表示.近几年来,卷积神经网络(Convolutional Neural Networks,简称CNN)在图像识别中取得了非常成功的应用,成为深度学习的一大亮点。

CNN发展至今,已经有很多变种,其中有几个经典模型在CNN发展历程中有着里程碑的意义,它们分别是:Alexnet、Googlenet、VGG、DRL等,这些卷积网络的都曾在ImageNet竞赛中获得过好成绩。

与他的导师Hinton一样,Lecun目前也进入了产业界,作为(纽约)大学教授以及Facebook 的首席人工智能科学家,他现在致力于联合学术界与产业界共同完成一些更实际的项目。

🔗 连载目录

🤖 智能推荐